CVPR2022 | PanopticDepth:深度感知全景分割的统一框架

作者:互联网

前言 本文提出了一种基于深度感知的全景分割(DPS)的统一框架,旨在从一幅图像中重建具有实例级语义的三维场景。该框架将动态卷积技术应用于全景分割(PS)和深度预测任务中,以生成特定于实例的内核来预测每个实例的深度和分割掩码。此外,利用实例级深度估计方案,添加了额外的实例级深度线索,以通过新的深度损失来帮助监督深度学习。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

论文:PanopticDepth: A Unified Framework for Depth-aware Panoptic Segmentation

论文:http://arxiv.org/pdf/2206.00468

代码:https://github.com/NaiyuGao/PanopticDepth.

背景

深度感知全景分割(DPS)是场景理解中的一项新的挑战性任务,它试图从单个图像构建具有实例级语义理解的三维场景。

DPS的一个简单解决方案是在全景分割(PS)网络中添加一个密集的深度回归头,为每个标记的像素生成一个深度值,该方法直观但次优。

由于它使用两个独立的分支处理这两个任务,因此它没有探索它们之间的互利关系,尤其是没有利用方便的实例级语义线索来提高深度准确性。

另外,作者观察到,相邻实例的像素通常具有不连续的深度。例如,一条线中的两辆车可能有不同的深度。因此,使用相同的像素深度回归器很难预测两辆车的准确深度。

另一方面,作者考虑到这些像素来自不同的车辆,如果分别使用单独的回归器,则有利于深度估计。

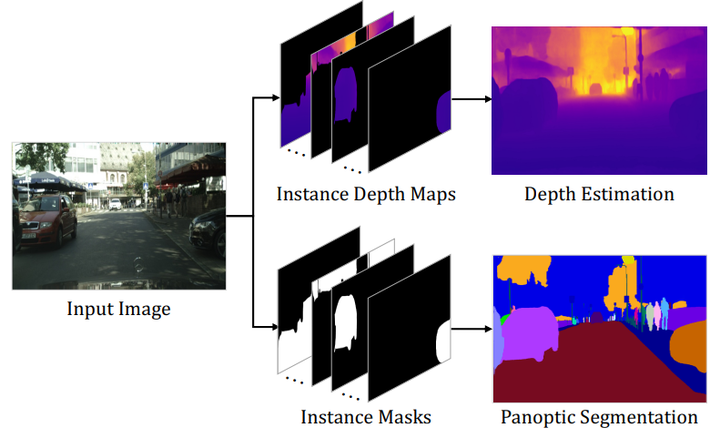

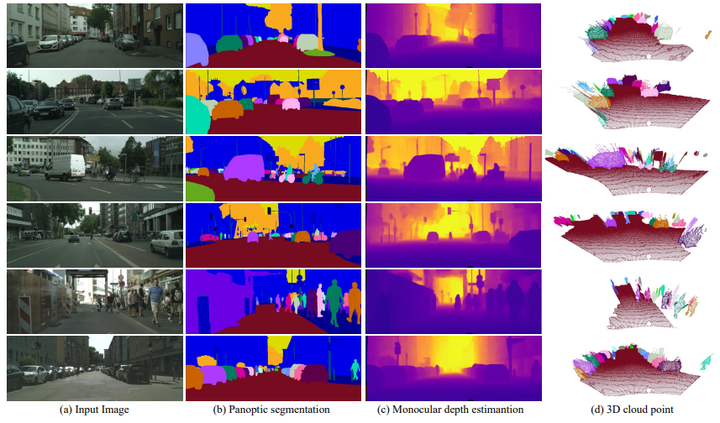

按照上述思路,作者在本文中提出了一个可以以相同的实例方式预测掩码和深度值的统一的PanopticDepth模型框架(如图1)。

图1 深度感知全景分割统一解决方案的示例

图1 深度感知全景分割统一解决方案的示例

贡献

1.提出了一种特定于实例的动态卷积核技术将深度估计和全景分割方法统一起来,从而提高了这两种任务的性能。

2.为了简化深度估计,受批量归一化的启发,提出将每个实例深度图表示为三元组,即归一化深度图、深度范围和深度偏移,将原始实例深度映射的值规范化为[0,1],以提高了学习效率。

3.基于新的深度图表示(如深度偏移)添加了实例级深度统计,以加强深度监控。为适应这种新的监督,提出了相应的深度损失,以改进深度预测。

方法

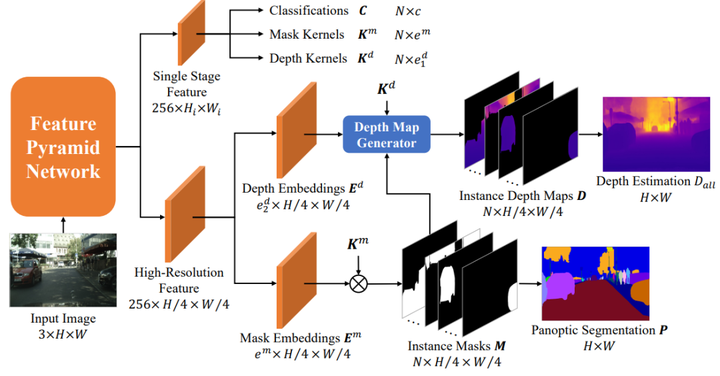

作者提出了一种统一的深度感知全景分割模型PanopticDepth,它以相同的实例方式预测掩模和深度值。除了主干网和特征金字塔网络之外,它还包括三个子网络,包括用于生成实例分类的核生成器、实例特定掩码和深度卷积核、用于生成实例掩码的全景分割模型以及用于估计实例深度的实例深度图生成器。网络架构如图2所示。

图2 PanopticDepth框架

图2 PanopticDepth框架

1.内核生成器

通过核生成器子网络生成实例分类、掩码卷积核和深度估计核(图2的上半部分)。内核生成器基于最先进的全景分割模型PanopticFCN,该模型采用了PS的动态卷积技术,与其他最新方法相比,所需的训练时间和GPU内存更少。

作者采用的内核生成器分为内核生成器和内核融合两个阶段。在内核生成器阶段,将FPN中第i阶段的一个单阶段特征作为输入,生成器生成一个内核权重映射,以及分别为对象和对象生成的两个位置映射,给定每个FPN阶段的位置图和核权重图,在核融合阶段,合并多个FPN阶段的重复核权重,通过提出的自适应核融合(AKF)操作实现的。

2.全景分割

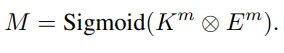

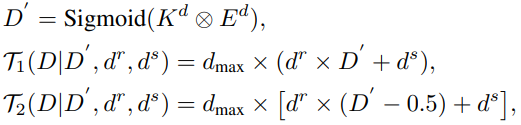

采用了一种特定于实例的核方法来执行全景分割,如图2底部所示。thing和stuff实例的掩码M是通过卷积共享的高分辨率掩码嵌入映射得到的∈ ,掩码核为,然后进行Sigmoid激活:

首先丢弃冗余实例掩码。然后,将所有剩余的实例掩码与argmax合并,以生成不重叠的全景分割结果,这样每个像素都被分配到一个事物或填充片段,而没有任何像素标记为“VOID”。

此外,作者还提出了一个额外的训练过程,即在全图像尺度上微调学习模型,但批量较小。以弥补训练和测试之间的性能差距。

3.基于实例的深度估计

通过在全景分割中使用的相同实例特定核技术来预测每个实例的深度,该技术将深度估计和全景分割的管道统一起来。如图2的中间部分所示,首先在深度嵌入上运行深度核以生成实例深度图,然后根据全景分割结果合并这些单独的图像以生成最终的整体深度图。

3.1深度生成器

给定实例特定深度内核Kd和共享深度嵌入Ed,类似于实例掩码生成过程,通过卷积和Sigmoid激活生成规范化的实例深度图D',然后通过等式4或等式5将其非规范化为深度图D:

其中深度图D′只对每个实例中的相对深度值进行编码,因此可以更容易地学习。此外,作者开发了两种归一化方案,即公式4和公式5,并发现后者效果更好。

在获得所有实例深度图之后,作者根据不重叠的全景分割掩码M将它们聚合为一个完整的图像深度图。这在实例边界处生成了精确的深度值。

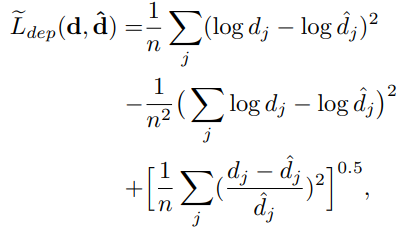

3.2深度损失

作者基于比例不变对数误差和相对平方误差的组合开发了深度损失函数,如下:

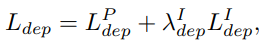

由于采用了基于实例的深度估计方法,作者在传统的像素级监控和额外的实例级监控下学习深度预测,这从经验上提高了深度精度。为了实现双重监督,最终深度损失Ldep包括两个损失项。一个是像素级深度损失,另一个是实例级深度损失:

实验

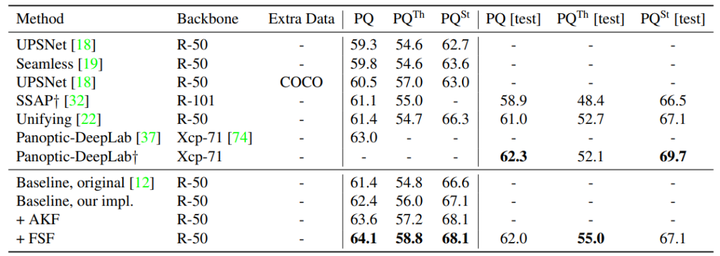

表1:城市景观验证和测试集的全景分割结果。”AKF:“自适应内核融合”FSF:全面微调

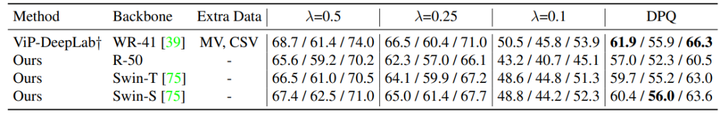

表2:城市景观DPS上的深度感知全景分割结果

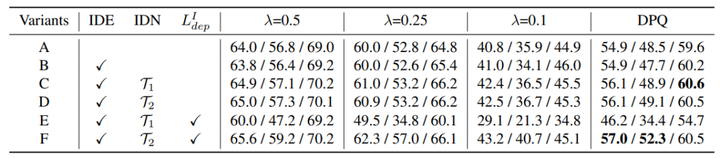

表3:城市景观DPS的消融研究。”IDE“:实例深度估计”IDN“:实例深度规范化

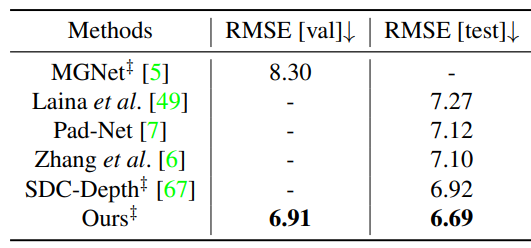

表4:城市景观的单目深度估计结果方法利用全景分割注释

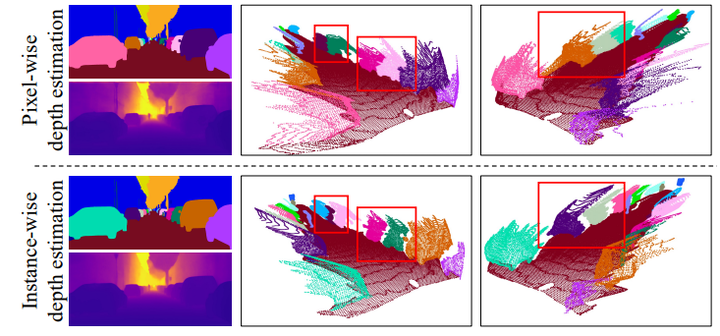

图3:像素级深度估计在两个实例的边界处输出平滑值,而实例级深度估计可以生成更合理的不连续深度值

图4:PanopticDepth模型的预测示例

结论

本文提出了一个统一的深度感知全景分割框架,生成特定于实例的内核来预测每个实例的深度和分割掩码。

采用动态核技术将高层目标信息引入深度估计,使用深度偏移和深度范围对每个实例深度图进行归一化,以简化共享深度嵌入的学习。

此外,本文还提出了一种新的深度损失方法来监督实例级深度线索的深度学习。在城市景观DPS和SemKITTI DPS基准上的实验证明了该方法的有效性。

CV技术指南创建了一个计算机视觉技术交流群和免费版的知识星球,目前星球内人数已经600+,主题数量达到200+。 知识星球内将会每天发布一些作业,用于引导大家去学一些东西,大家可根据作业来持续打卡学习。 技术群内每天都会发最近几天出来的顶会论文,大家可以选择感兴趣的论文去阅读,持续follow最新技术,若是看完后写个解读给我们投稿,还可以收到稿费。 另外,技术群内和本人朋友圈内也将发布各个期刊、会议的征稿通知,若有需要的请扫描加好友,并及时关注。 加群加星球方式:关注公众号CV技术指南,获取编辑微信,邀请加入。 欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

其它文章

计算机视觉入门路线 CVPR2022 | iFS-RCNN:一种增量小样本实例分割器 CVPR2022 | Time 3D:用于自动驾驶的端到端联合单目三维物体检测与跟踪 CVPR2022 | A ConvNet for the 2020s & 如何设计神经网络总结 CVPR2022 | PanopticDepth:深度感知全景分割的统一框架 CVPR2022 | 重新审视池化:你的感受野不是最理想的 CVPR2022 | 未知目标检测模块STUD:学习视频中的未知目标 CVPR2022 | 基于排名的siamese视觉跟踪 CVPR2022 | 通过目标感知Transformer进行知识蒸馏 CVPR2022丨无监督预训练下的视频场景分割 从零搭建Pytorch模型教程(六)编写训练过程和推理过程 从零搭建Pytorch模型教程(五)编写训练过程--一些基本的配置 从零搭建Pytorch模型教程(四)编写训练过程--参数解析 从零搭建Pytorch模型教程(三)搭建Transformer网络 从零搭建Pytorch模型教程(二)搭建网络 从零搭建Pytorch模型教程(一)数据读取 一份热力图可视化代码使用教程 一份可视化特征图的代码 关于快速学习一项新技术或新领域的一些个人思维习惯与思想总结

标签:分割,深度图,实例,全景,PanopticDepth,深度,掩码,感知,CVPR2022 来源: https://www.cnblogs.com/wxkang/p/16365560.html