大数据技术之Kafka 第4章 Kafka 自定义Interceptor

作者:互联网

4.3 自定义Interceptor

4.3.1 拦截器原理

Producer拦截器(interceptor)是在Kafka 0.10版本被引入的,主要用于实现clients端的定制化控制逻辑。

对于producer而言,interceptor使得用户在消息发送前以及producer回调逻辑前有机会对消息做一些定制化需求,比如修改消息等。同时,producer允许用户指定多个interceptor按序作用于同一条消息从而形成一个拦截链(interceptor chain)。Intercetpor的实现接口是org.apache.kafka.clients.producer.ProducerInterceptor,其定义的方法包括:

(1)configure(configs)

获取配置信息和初始化数据时调用。

(2)onSend(ProducerRecord):

该方法封装进KafkaProducer.send方法中,即它运行在用户主线程中。Producer确保在消息被序列化以及计算分区前调用该方法。用户可以在该方法中对消息做任何操作,但最好保证不要修改消息所属的topic和分区,否则会影响目标分区的计算。

(3)onAcknowledgement(RecordMetadata, Exception):

该方法会在消息从RecordAccumulator成功发送到Kafka Broker之后,或者在发送过程中失败时调用。并且通常都是在producer回调逻辑触发之前。onAcknowledgement运行在producer的IO线程中,因此不要在该方法中放入很重的逻辑,否则会拖慢producer的消息发送效率。

(4)close:

关闭interceptor,主要用于执行一些资源清理工作

如前所述,interceptor可能被运行在多个线程中,因此在具体实现时用户需要自行确保线程安全。另外倘若指定了多个interceptor,则producer将按照指定顺序调用它们,并仅仅是捕获每个interceptor可能抛出的异常记录到错误日志中而非在向上传递。这在使用过程中要特别留意。

4.3.2 拦截器案例

1)需求:

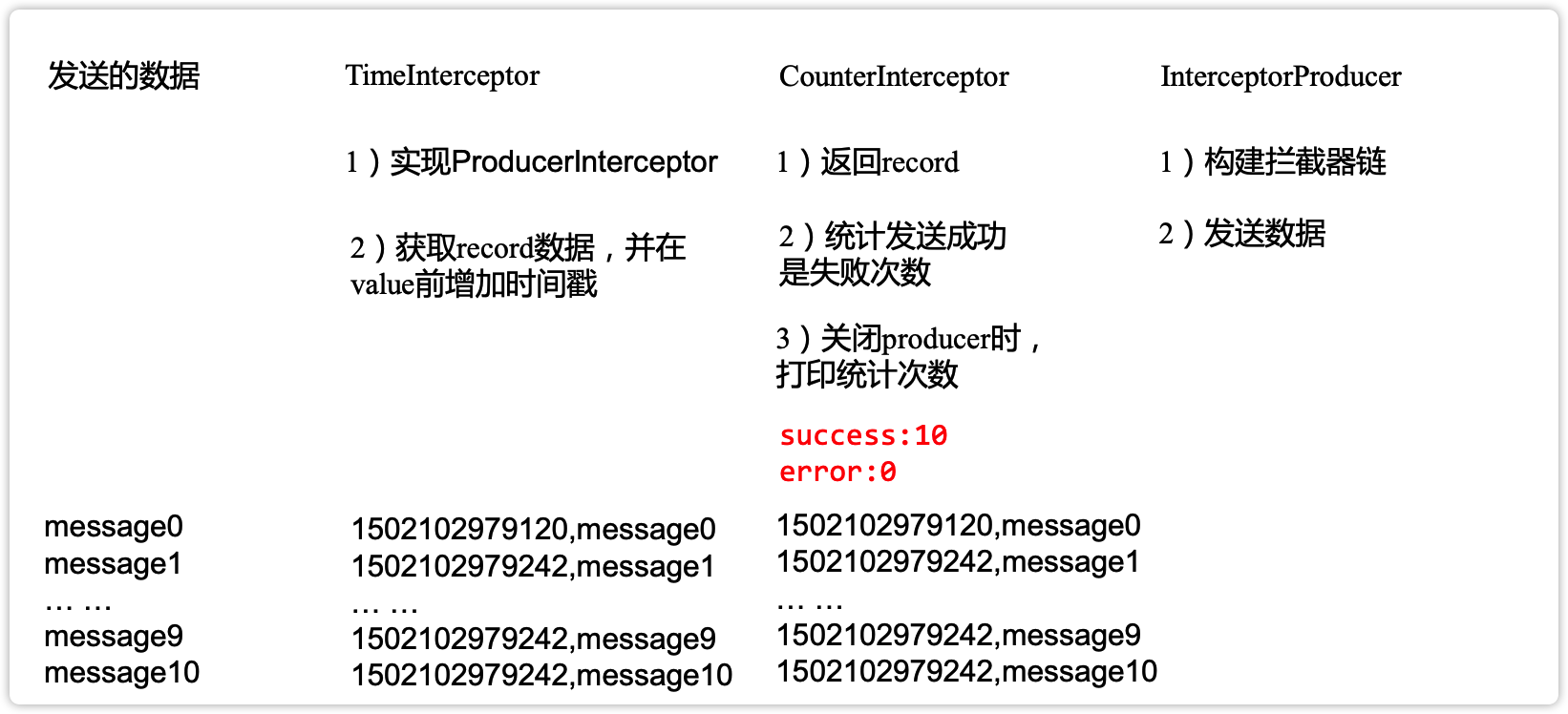

实现一个简单的双interceptor组成的拦截链。第一个interceptor会在消息发送前将时间戳信息加到消息value的最前部;第二个interceptor会在消息发送后更新成功发送消息数或失败发送消息数。

2)案例实操

(1)增加时间戳拦截器

package com.wolffy.kafka.interceptor;

import com.sun.org.apache.regexp.internal.RE;

import org.apache.kafka.clients.producer.ProducerInterceptor;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Map;

/**

* 该拦截器实现的功能:

* 将时间戳添加到消息的前面.

*/

public class TimeStampInterceptor implements ProducerInterceptor<String,String> {

/**

* 拦截器的核心处理方法

* @param record 被拦截处理的消息

* @return

*/

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> record) {

// 1. 获取消息的value

String value = record.value();

String result = System.currentTimeMillis() + "->" + value ;

//2. 重新构建新的消息对象

ProducerRecord<String, String> newRecord =

new ProducerRecord<>(record.topic(), record.partition(), record.key(), result);

return newRecord;

}

@Override

public void onAcknowledgement(RecordMetadata metadata, Exception exception) {

}

@Override

public void close() {

}

@Override

public void configure(Map<String, ?> configs) {

}

}

(2)统计发送消息成功和发送失败消息数,并在producer关闭时打印这两个计数器

package com.wolffy.kafka.interceptor;

import org.apache.kafka.clients.producer.ProducerInterceptor;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Map;

/**

* 该拦截器实现的功能:

* 统计发送成功和失败的消息个数

*/

public class CountInterceptor implements ProducerInterceptor<String,String> {

private int success ;

private int fail ;

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> record) {

return record;

}

@Override

public void onAcknowledgement(RecordMetadata metadata, Exception exception) {

if(exception != null){

fail ++ ;

}else{

success ++ ;

}

}

@Override

public void close() {

System.out.println("SUCCESS: " + success);

System.out.println("FAIL: " + fail);

}

@Override

public void configure(Map<String, ?> configs) {

}

}

(3)producer主程序

package com.wolffy.kafka.interceptor;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.ArrayList;

import java.util.List;

import java.util.Properties;

/**

* 生产者 - 拦截器

*/

public class KafkaProducerInterceptor {

public static void main(String[] args) {

//0. 创建配置对象

Properties props= new Properties();

//kafka集群,broker-list

props.put("bootstrap.servers", "hadoop102:9092");

// ack的级别

props.put("acks", "all");

//重试次数

props.put("retries", 3);

//批次大小

props.put("batch.size", 16384);

//等待时间

props.put("linger.ms", 1);

//RecordAccumulator缓冲区大小

props.put("buffer.memory", 33554432); //32M

// kv的序列化器

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 配置拦截器

List<String> interceptors = new ArrayList<String>();

interceptors.add("com.wolffy.kafka.interceptor.TimeStampInterceptor");

interceptors.add("com.wolffy.kafka.interceptor.CountInterceptor") ;

props.put(ProducerConfig.INTERCEPTOR_CLASSES_CONFIG,interceptors);

//1. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<String, String>(props);

//2. 生产数据

for (int i = 0; i < 20 ; i++) {

kafkaProducer.send(new ProducerRecord<String,String>("first", "wolffy" + i));

}

//3. 关闭对象

kafkaProducer.close();

}

}

3)测试

(1)在kafka上启动消费者,然后运行客户端java程序。

[wolffy@hadoop102 kafka]$ bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --from-beginning --topic first

1501904047034,message0

1501904047225,message1

1501904047230,message2

1501904047234,message3

1501904047236,message4

1501904047240,message5

1501904047243,message6

1501904047246,message7

1501904047249,message8

1501904047252,message9

IT学习网站

牛牛IT网站:https://www.cowcowit.com/

Kafka学习资源推荐

Kafka多维度系统精讲-从入门到熟练掌握

链接: https://pan.baidu.com/s/1fvhFRu9eExVKq8tGr3mPsw 提取码: 2mdb

--来自百度网盘超级会员v4的分享

失效加V:x923713

标签:自定义,producer,kafka,org,apache,import,interceptor,Kafka,Interceptor 来源: https://www.cnblogs.com/niuniu2022/p/16345816.html