MLP

作者:互联网

1、神经网络:神经网络的变种目前有很多,如误差反向传播(Back Propagation,BP)神经网路、概率神经网络、卷积神经网络(Convolutional Neural Network ,CNN-适用于图像识别)、时间递归神经网络(Long short-term Memory Network ,LSTM-适用于语音识别)等。但最简单且原汁原味的神经网络则是多层感知器(Multi-Layer Perception ,MLP),只有理解经典的原版,才能更好的去理解功能更加强大的现代变种。

- MLP

- BP

- CNN

- LSTM

- ......

MLP(MLP神经网络不同层之间是全连接的):

神经网络的结构

- 输入层(input)、隐藏层(hidden layers)、输出层(output)

- 全连接(上一层的任何一个神经元与下一层的所有神经元都有连接)

- 神经网络主要有三个基本要素:权重、偏置和激活函数

-

权重:神经元之间的连接强度由权重表示,权重的大小表示可能性的大小

-

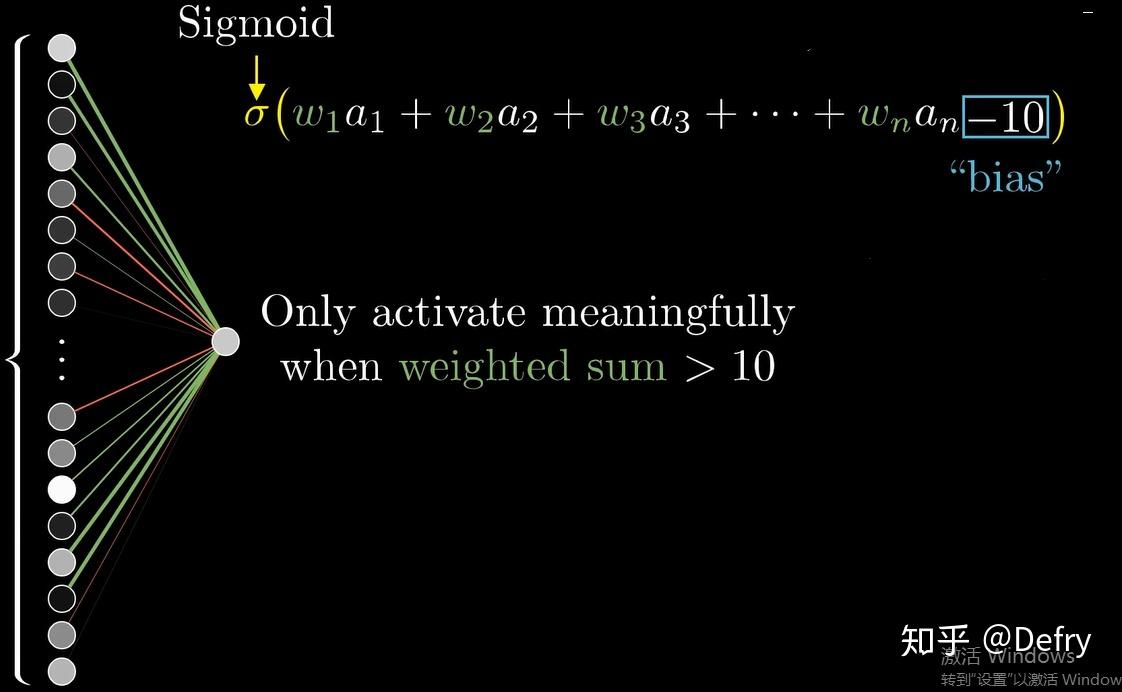

偏置:偏置的设置是为了正确分类样本,是模型中一个重要的参数,即保证通过输入算出的输出值不能随便激活。

-

激活函数:起非线性映射的作用,其可将神经元的输出幅度限制在一定范围内,一般限制在(-1~1)或(0~1)之间。最常用的激活函数是Sigmoid函数,其可将(-∞,+∞)的数映射到(0~1)的范围内。

- 激活函数:tanh、relu、elu、linear、prelu、leaky_relu、softplus

- tanh是Sigmoid函数的变形,tanh的均值是0,在实际应用中有比Sigmoid更好的效果;ReLU是近来比较流行的激活函数,当输入信号小于0时,输出为0;当输入信号大于0时,输出等于输入;

- 下层单个神经元的值与上层所有输入之间的关系可通过如下方式表示,其它以此类推。

- 前向传播推导过程

神经网络的训练和学习

标签:函数,神经网络,MLP,激活,输入,神经元 来源: https://www.cnblogs.com/Monster1728/p/15834742.html