14 Positional Encoding (为什么 Self-Attention 需要位置编码)

作者:互联网

博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看

配套 github 链接:https://github.com/nickchen121/Pre-training-language-model

配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html

厚颜无耻的要个赞

Attention

优点:

- 解决了长序列依赖问题

- 可以并行

缺点:

-

开销变大了

-

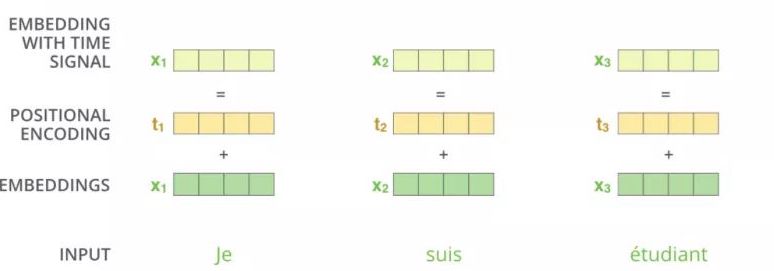

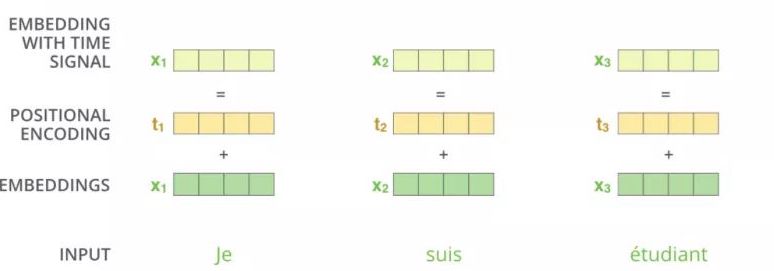

既然可以并行,也就是说,词与词之间不存在顺序关系(打乱一句话,这句话里的每个词的词向量依然不会变),即无位置关系(既然没有,我就加一个,通过位置编码的形式加)

位置编码的问题

为什么需要位置编码

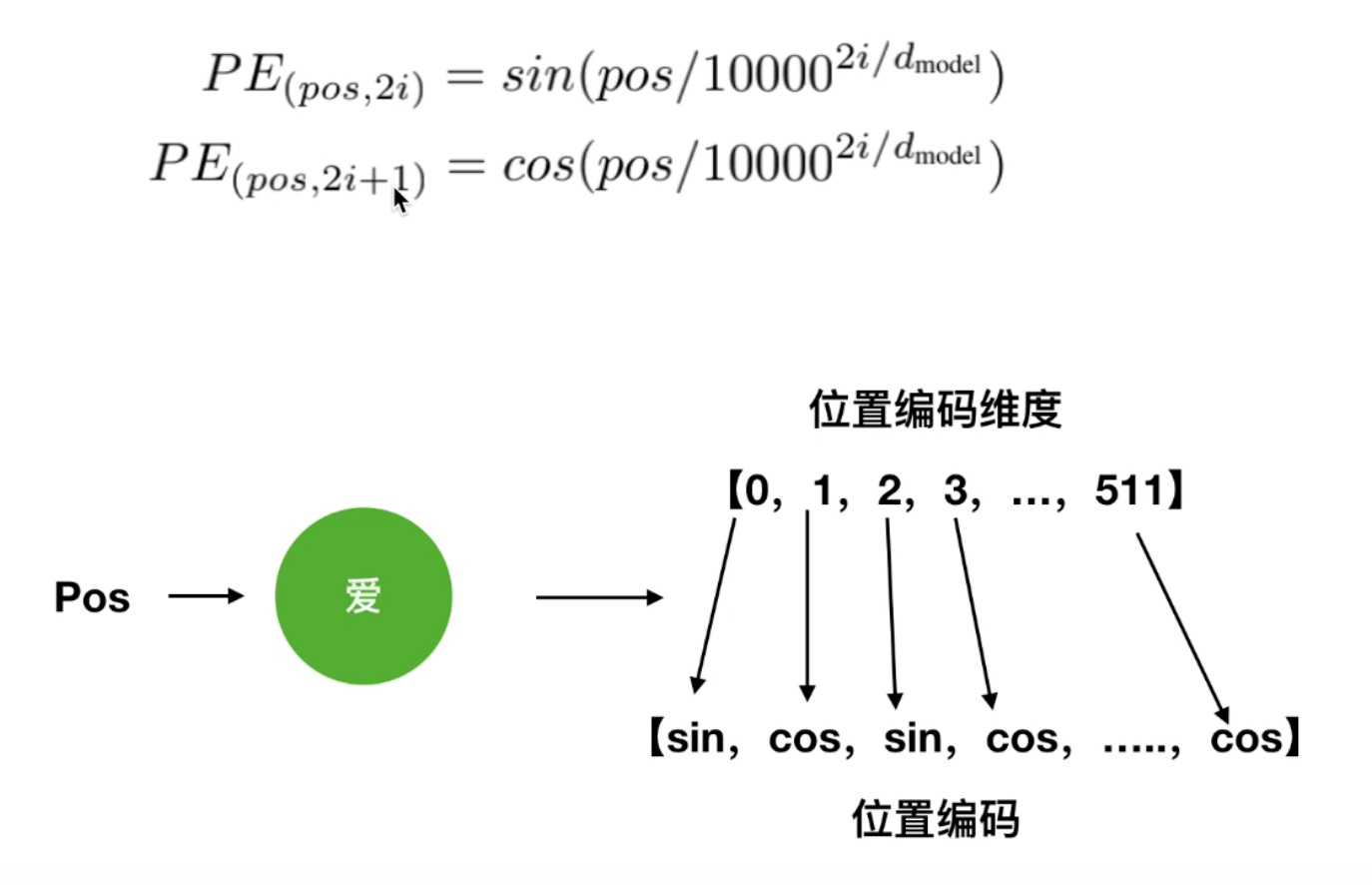

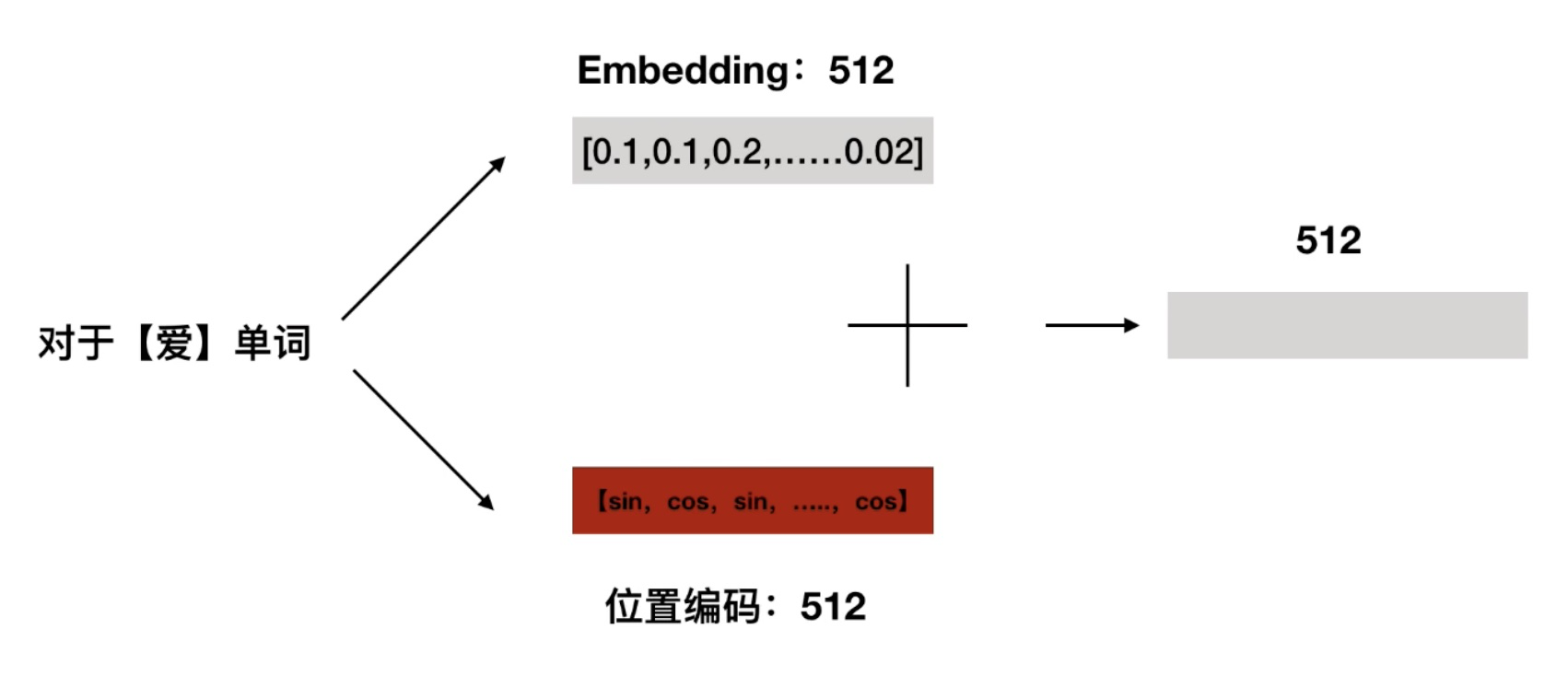

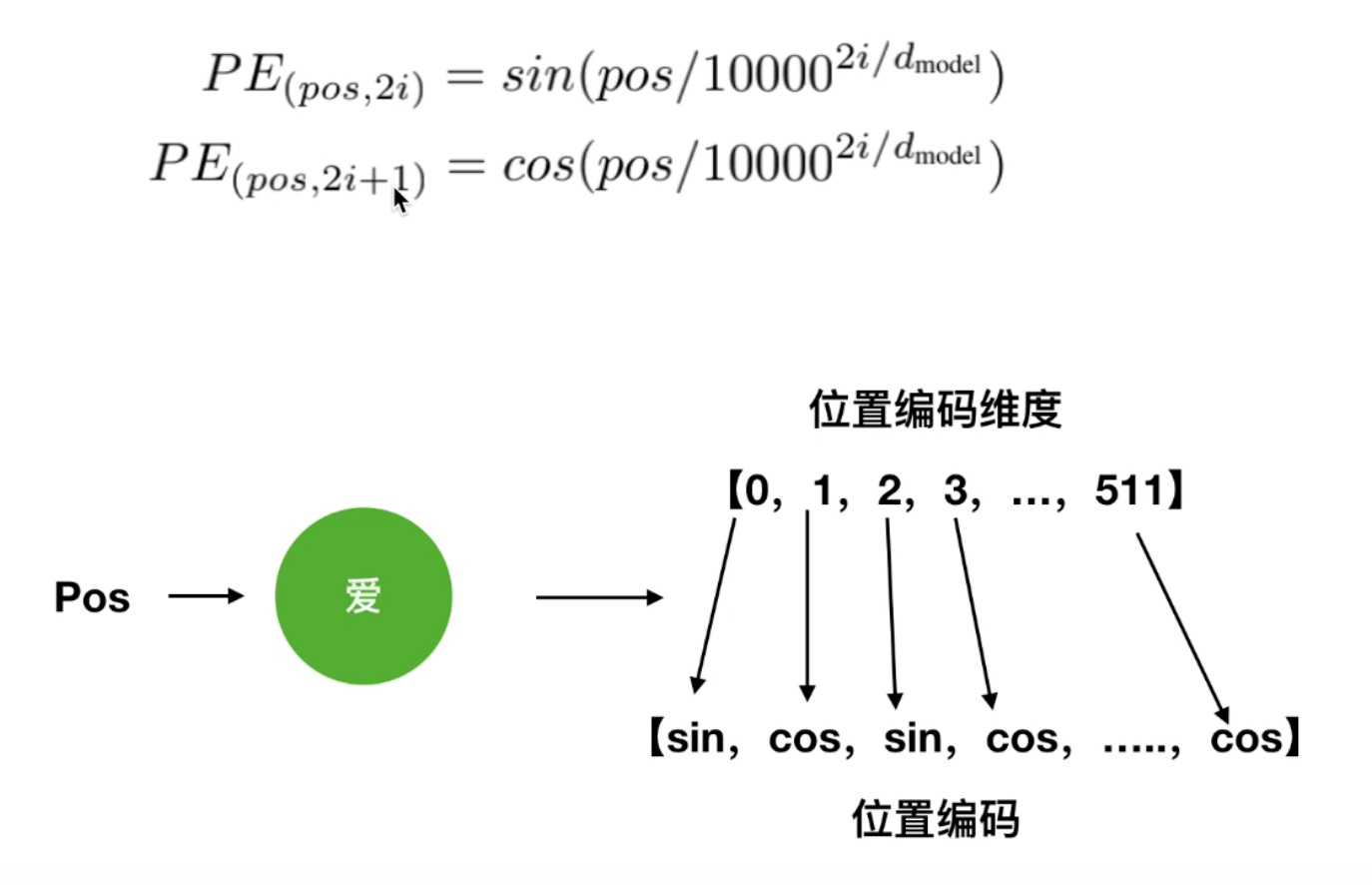

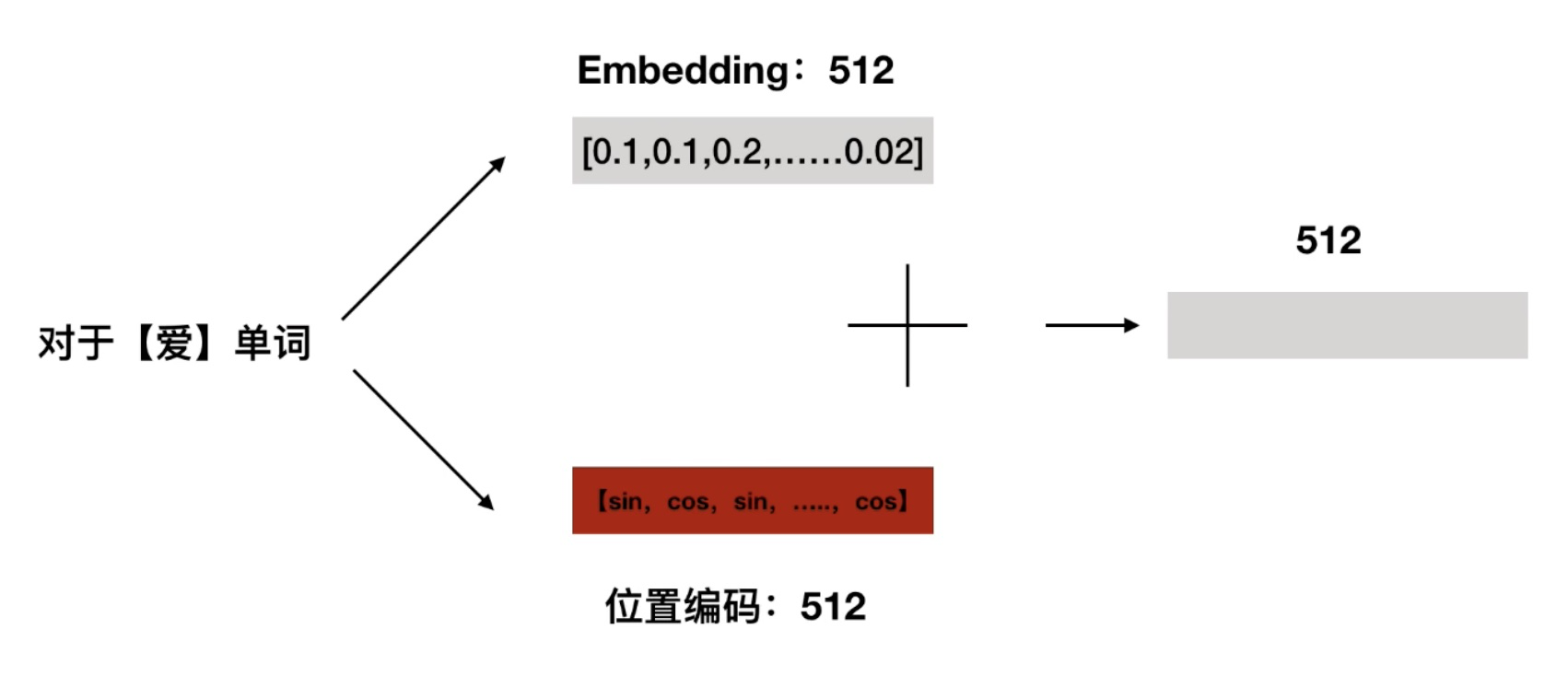

位置编码怎么做的

具体做法

做法 1

做法 2

为什么这么做有用

pos+K=5,我在计算第 5 个单词的位置编码的时候

pos=1,k=4

pos=2,k=3

标签:编码,14,Encoding,Self,位置,pos,https,com,链接 来源: https://www.cnblogs.com/nickchen121/p/16470736.html